摘要

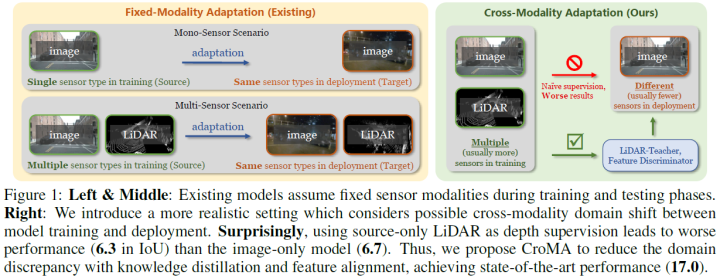

结合多种传感器模式和缩小训练和部署之间的领域差距是自动驾驶的两个挑战性且关键的主题。现有域适应工作只关注视觉层级的域差距,而忽略了现实中存在的传感器类型差距。使用多传感器模态训练的模型可能需要在可用传感器类型较少的另一设置上运行。基于此,论文提出了一个跨模态自适应(CroMA)框架,以便于学习更健壮的单目BEV感知模型,该模型在训练阶段将点云知识馈送到纯视觉测试场景。测试期间没有激光雷达,因此无法将其用作模型输入。因此,论文的关键思想在于设计(i)一个LiDAR教师和相机学生知识蒸馏模型,以及(ii)一个多层次的对抗学习机制,该机制适应并调整从不同传感器和领域学习到的特征。论文首次对室外单目3D任务的跨域感知和跨传感器适应进行了开放性分析,并在大范围的域偏移条件下对大规模数据集进行基准测试,并根据各种基准展示SOTA的结果!!

本文的主要贡献如下:

本文引入了模态失配,这是一个在室外3D域适应中被忽视但现实的问题设置,会导致了一个强大的仅使用相机的3D模型,该模型可在复杂和动态场景中工作,且可用传感器最少;

论文提出了一种新颖的激光雷达-教师和相机-学生知识蒸馏模型,该模型明显优于先进的激光雷达监督方法;

在具有挑战性的域偏移设置中的大量实验证明了,CroMA在利用源域点云信息实现准确的单目3D感知方面的能力。

方法

论文考虑学习具有域偏移和模态失配场景下的BEV感知任务。具体而言,该模型将在源域中提供带标注的激光雷达点云和相机图像,但仅在目标域中提供未标注的相机图像。该模型力求在无监督的目标域上实现最高性能。这种问题值得探索,特别是考虑到许多现有的公共多模态数据集的存在以及许多只使用摄像机的车辆场景的兴起。

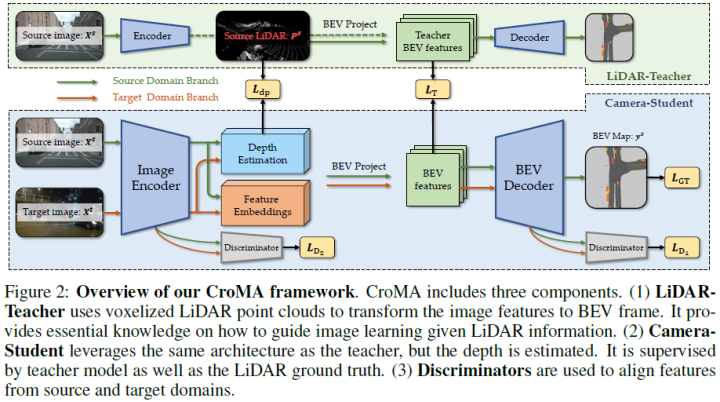

在形式上,对于源域得到了带有个多模态样本的标记数据,s表示源域。包含n个相机图像,相机的个数n取决于数据集配置或车辆部署的相机数量。此外,每个相机图像都有内外参。是包含由3D坐标值表示的多个无序点p的点云。真值表示BEV坐标中场景的栅格化表示。对于目标域,得到了具有个单模态(图像)样本的未标记数据。CroMA框架如下图所示:

从图像中学习BEV

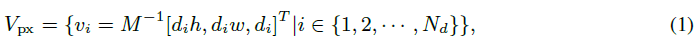

为了实现跨模态3D感知,第一个面临的挑战就是将图像帧、点云帧和BEV帧统一到一个联合空间中。论文通过为每个输入图像构建场景的3D体素表示来解决这个问题。即将深度轴离散为个单元,并将图像的每个像素提升为multiple voxels(frustums),其中每个体素由其中心位置的3D坐标表示。对于相机图像中的一个给定像素,它对应于不同深度区域的一组体素。

在获得每个体素的特征后,进一步将体素投影到BEV上,并聚合特征以获得BEV特征图。BEV帧被栅格化为(X,Y)2D网格,对于每个网格,其特征由使用mean pooling投影到其中的所有3D体素的特征构建。这种投影允许将任意数量的相机图像转换为统一的BEV帧。经过上述步骤获得了一个类似图像的BEV特征嵌入,该特征嵌入用于使用CNN解码器估计最终表示。

综上可知,CroMA通过中间3D体素化表示将图像和LiDAR模态连接起来。因此,论文可以将LiDAR点云输入到模型中,以直接引导BEV投影,而无需改变整个管道。这进一步使得能够使用师生模型将知识从点云蒸馏到图像。

跨模态迁移与教师-学生蒸馏

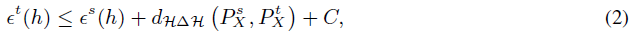

尽管这是一项面向应用的工作,但论文对该领域提供了简短的理论见解,以证明更现实的问题设置所带来的挑战,并进一步推动论文架构的设计。证明了在域适应中,目标域误差可以由以下不等式确定上界(Ben-David et al., 2010):

点云深度监督:点云相对于图像模态的主要优点是来自深度测量的精确3D位置信息。由于测试时缺少激光雷达,所以无法使用点云作为模型的直接输入。因此,使用点云的一种替代方法是监督模型中的深度估计。如等式1所示,对于每个像素,CroMA通过将像素体素乘以深度值来计算其对应体素的特征。论文使用另一个深度头来预测每个像素的深度。

深度估计的GT由LiDAR点云生成,如下所示:当投影到图像帧时,对应于一个像素的点云可以有三个条件。如果像素具有(1)内部没有点云:它的深度GT分布被忽略。(2) 只有一个点云在里面:该点的深度GT分布是一个one-hot矢量,值1位于该点云所在的体素中。(3) 内部多个点云:该点的深度GT分布通过计算每个depth bin中的点云数,并除以点云总数来计算。

使用基于分布的深度表示有效地解决了当不同深度的目标出现在一个像素中时的模糊性。这种情况发生在目标的边界处,当图像在特征编码期间经过下采样并且像素变大时,这种情况会变得更加严重。此外,概率深度表示考虑了深度估计过程中的不确定性,如果添加了one-hot约束,则会退化为伪激光雷达方法(Weng&Kitani,2019)。

Learning from LiDAR-Teacher:尽管直观和直接,但直接进行深度监督并不是最佳的,原因有两个。首先,LiDAR监督仅在中间特征层上,无法对模型的后半部分进行监督。此外,虽然激光雷达提供准确的深度测量,但“深度估计”与论文在BEV表示方面的整体目标仍然不同。基于此,如图2所示,论文在最终BEV特征嵌入时使用预训练的LiDAR模型来监督视觉模型,从而将LiDAR的监督信息提供给整个模型,并且更接近最终目标。论文将使用GT点云信息的模型称为“LiDAR教师”,将被监督的模型称之为“相机学生”。这可以归结为一个知识蒸馏问题,即LiDAR教师的3D推理知识被提取给纯视觉的学生。请注意,由于容量不匹配,该模型中不存在知识蒸馏中的经典问题“better teacher, worse student”(Cho&Hariharan,2019;Mirzadeh等人,2020;Zhu&Wang,2021),因为CroMA中的LiDAR教师和相机学生模型几乎相同。

总体而言,这种教师-学生机制允许相机模型从点云学习更好的3D表示,在不同阶段实现更完整的LiDAR监督,同时仍然保持模型以视觉为中心,仅用于图像推断。

具有对抗特征对准的跨域自适应

由于BEV标注和激光雷达GT仅在源数据中可用,因此在教师-学生监督期间,模型将严重偏向源分布。基于此,论文使用对抗训练将目标域和源域连接起来。具体而言,论文将一个判别器放置在BEV解码器CNN处,另一个放置在图像编码器CNN上,以通过优化过判别器损失来对齐两个域的特征。虽然始终有助于将从LiDAR教师那里学习到的特征与GT进行对齐,但论文发现,在图像有很大变化但LiDAR仍然健壮的某些域差距下,判别器特别有效。

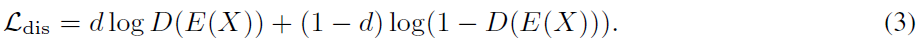

为了进行对抗学习,给定特征编码器E和输入样本X,使用判别器D来区分特征来自源域还是目标域。目标域样本和源域样本分别被赋予标签d=1和d=0。输出样本X属于目标域的概率。因此,判别器损失由交叉熵损失表示:

此外,为了学习域不变性特征,特征编码器E应该尝试提取欺骗判别器D的特征,而判别器D则尝试区分样本的正确域标签。这种对抗策略可以表述为“最小-最大”优化问题:。“最小-最大”问题通过Gradient Reverse Layer(GRL)实现(Ganin&Lempitsky,2015),该层从判别器D生成反向梯度,以学习域不变编码器E。和的损失形式相同。

FULL OBJECTIVE AND INFERENCE

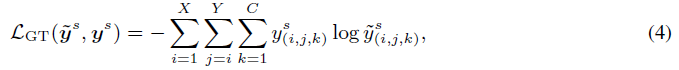

CroMA的整体损失由BEV GT、激光雷达教师和域对准判读的监督组成。给定输出栅格化BEV表示映射,GT损失项L可表示为估计的源域BEV图和GT标签之间的交叉熵损失:

LiDAR教师的监督由直接深度估计损失和教师特征监督组成。给定3D深度体积,直接深度监督项表示为源域中估计的3D深度分布体积与激光雷达点云计算的GT深度体积之间的交叉熵损失:

对于LiDAR教师特征的监督使用L2损失函数。多任务优化的损失函数如下所示:

实验

数据集和域设置

论文在nuScenes和Lyft数据集上展开实验。前三个域设置是nuScenes数据集的子样本,包括city-to-city、day-to-night以及dry-to-rain适应。此外,论文还进行另一个跨数据集域迁移:dataset-to-dataset的自适应,其中源和目标域数据来自nuScenes和Lyft数据集。所有域偏置设置都遵循这样的假设:源可以访问相机和激光雷达传感器,而目标域只有摄像机。各种消融研究也验证了每个成分的有效性,并分析了关于多模态和跨模态性能的令人惊讶的观察结果。

结果和对比

基线

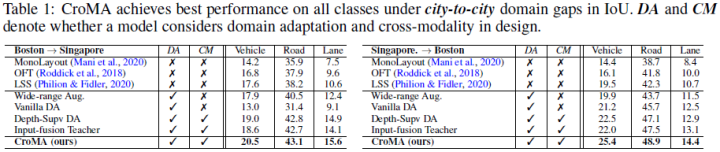

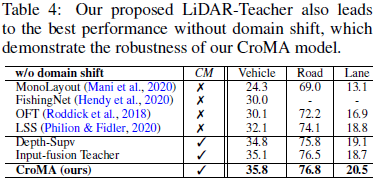

论文将CroMA与最先进的BEV 3D感知工作MonoLayout(Mani等人,2020)、OFT(Roddick等人,2018)、LSS(Philion&Fidler,2020)以及域适应和跨模态学习中的其他基线方法进行了比较。Wide-range Aug.意味着使用可能包括目标域范围的大尺度随机缩放增强。对于Vanilla DA,论文将纯视觉的DA-Faster(Chen等人,2018)调整为BEV感知设置。Depth-Supv DA代表深度监督域适应。论文使用源域LiDAR作为GT来监督训练期间的深度估计,无需LiDAR教师监督(仅无)。Input-fusion Teacher是设计LiDAR教师的另一种方式,即将点云(x,y,z)坐标直接融合到教师模型中的相应图像像素中,作为附加通道,类似于Pointpainting(Vora等人,2020)。此外使用DA和CM来表示模型在设计中是否考虑了领域适应和跨模态。实验结果报告了车辆、可行驶道路和车道标线等级,使用IoU进行评估。

City-to-City Adaptation

如表1所示,论文发现CroMA模型在两个inter-city迁移设置的所有类别上都达到了最佳性能。如果没有域适应,基线方法MonoLayout、OFT和LSS性能都会下降。考虑到视觉域的变化,大尺度增强和vanilla域适应方法将基线提高到11.2。直接深度监督和input-fusion teacher模型没有CroMA带来那么多的改进。通过提取和对齐用于跨模态域自适应3D BEV感知的LiDAR信息,证明了CroMA的有效性。

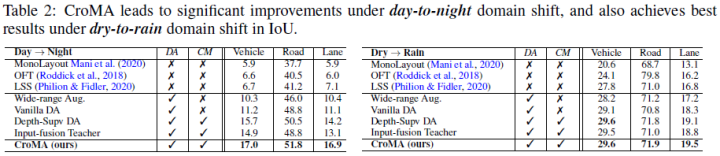

Day-to-Night Adaptation

如表2所示,CroMA在所有类中都达到了最佳性能。与之前的设置不同,Day→Night提升很大。这是因为在相机模态空间中,白天和夜晚场景之间的初始域差距非常大。此外,由于其主动成像机制而不是相机的被动成像机制,LiDAR传感器在照明变化下具有鲁棒性。因此,结合LiDAR点云信息有助于模型从图像输入中学习更鲁棒的照明不变表示。

Dry-to-Rain Adaptation

如表2所示,在这种设置下,CroMA在所有类上都达到了最佳性能。然而,论文注意到,Dry→Rain的提升相比日夜转换没那么大,并且仅与其他可选的跨模态基线相同。这是因为在图像模式中,干燥和下雨场景之间的域差距不大。因此即使没有领域适应,基线方法OFT和LSS已经能够获得良好的结果。此外,已知降雨天气会导致激光雷达发生大规模域偏移(Xu等人,2021)。因此,从源LiDAR获得的知识受未知域偏移影响,其可能大于图像模态域偏移。这可能会抵消从点云学习到的3D信息的增益,并解释了较小的改进。

Dataset-to-Dataset Adaptation

如表3所示,CroMA在nuScenes→ Lyft中实现了最优性能。根据Philion&Fidler(2020),由于Lyft在高清地图中不提供路段和车道标记信息,因此论文只展示了车辆的结果。请注意,Lyft数据集上没有预训练和拆分的验证集。与使用或不使用域适应或跨模态学习的基线相比,CroMA在利用和调整激光雷达信息方面做得更好。

可视化结果

如图3所示,在Day→Night域便宜设置,CroMA比vanilla DA和Depth-Supv DA基线实现了更好的单目3D感知。论文发现CroMA提供了更清晰的道路边界和车道标记。车辆的深度和尺寸以及右侧道路的预测也更加准确。CroMA只错过了一些由于遮挡和距离而在相机中几乎看不见的车辆。总体而言,定性结果验证了CroMA在缩小数据域之间的差距以及利用点云信息进行更好的3D推断方面的有效性。

令人惊讶的观察和消融研究分析

单纯使用更多传感器会导致性能下降

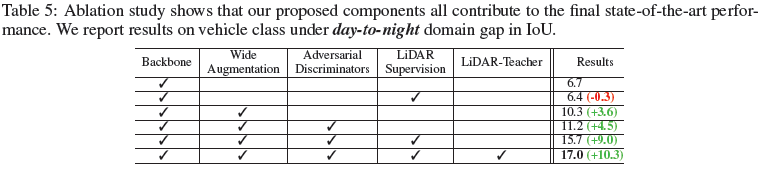

人们自然相信,在感知模型中引入多个传感器必然会提高模型性能。令人惊讶的是,表5中的实验否定了这种天真的直觉。当我们在源域中引入LiDAR传感器作为深度监控时,结果会降低0.3。引入传感器模态偏移后,域分布发散度会增加。因此,论文在CroMA中提出了多个组件,以解决视觉和传感器域偏移问题。实验表明,虽然wide augmentation策略和对抗判别器都能获得比基线更好的结果(在IoU中为11.2对6.7),但CroMA的LiDAR教师通过有效的LiDAR知识蒸馏和对齐,将结果进一步提高到17.0。

处理混合域偏移

论文在3D域适应中观察到的另一个常见但未充分探索的问题是混合域偏移问题,其中源域和目标域之间的多种类型的间差距经常同时出现。例如,在nuScenes数据集中,波士顿数据仅在白天捕获,而新加坡数据则在白天和夜晚捕获。这导致了这样一个事实:新加坡域中的一些数据与源之间仅存在city-wise的差距,而另一部分数据则存在city-wise和illumination-wise的差距。如表4所示,论文发现在这种情况下直接利用对抗学习会导致比直接推断(在没有域适应的情况下训练模型)更差的性能,因为目标域中的混合域会混淆域判别器。因此,论文提出了一种渐进式学习机制,在该机制中首先对城市数据进行100K step的自适应,然后在完整的目标域数据集上对模型进行150K step的训练。这有效地缓解了混合域偏移问题,并帮助CroMA实现了优于其他基线的领先结果。

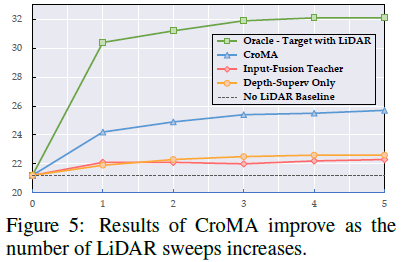

Effect on LiDAR Density & Comparison with Oracle Model

如图5所示,论文验证了当更密集的激光雷达可用时,CroMA可以实现更高的性能。这可以通过将LiDAR点云的连续扫描(从1到5)聚类为一个整体来实现,以获得更密集的场景3D表示。论文发现,其他跨模态基线(包括Input-Fusion Teacher和Depth-Supv模型)无法有效利用激光雷达知识,即使有密集的点云可用。论文还将CroMA与LiDAR oracle模型(目标域也具有LiDAR模态)进行比较,发现上限结果与无LiDAR基线之间的差距显著减小。剩余的性能差距是由未知的LiDAR域差距造成的,论文希望在未来的工作中进一步缩小这种差距。

结论

本文提出了CroMA来估计在域偏移和模态变化下BEV中的3D场景表示。为了实现这一点,论文构建了一个LiDAR教师,并通过特征监督将其知识蒸馏到纯视觉学生中。论文进一步建议使用多阶段对抗学习来对齐域之间的特征空间。在具有各种挑战性域差距的大规模数据集上的结果证明了CroMA的有效性,这标志着在室外实现稳健的3D场景感知方面迈出了重要一步。

计算机视觉研究院

计算机视觉研究院

集智书童

集智书童

极市平台

极市平台

Jack Cui

Jack Cui